L’IA est (presque) partout, de Chat GPT à MidJourney pour les plus connues, à celles d’Adobe et de Canva pour la création, en passant par les LLM de Mistral et d’Anthropic, et par toutes celles utilisées dans les secteurs de la Santé et de l’Industrie, il est plus que difficile de s’y retrouver. Pire encore, quand il s’agit de votre organisation, outre le choix des modèles, si des obligations vous contraignent à les entrainer en local, le choix du matériel est crucial !

Il est évident que le Cloud Computing permet l’abstraction des ressources techniques et des contraintes qui sont liées à leur déploiement, mais il est parfois, au-delà des impératifs, plus judicieux et plus économique d’investir dans une infrastructure AI-oriented que de payer des heures de calcul, dont la facture mensuelle peut très rapidement grimper.

Une infrastructure dédiée peut aussi rassurer vos clients, vous faire gagner en compétitivité, et vous permettre de réellement contrôler le fine-tuning des modèles utilisés.

Vous l’aurez compris, de plus en plus d’organisations choisissent d’investir dans les ressources adéquates afin d’assurer la gouvernance et la souveraineté de l’IA.

Pour correctement concevoir une infrastructure de calcul pour l’IA, notamment avec les serveurs ou les workstations sur lesquels vous déploierez les algorithmes, vous devez retenir plusieurs considérations : La technologie utilisée et son niveau de compétitivité (comprenez ici quel(s) GPU(s) vous serez amenés à choisir), la consommation énergétique totale de vos équipements, le niveau de technicité requis pour leur opérabilité et, bien entendu, le coût total de l’infrastructure. Mais si, comme beaucoup, les spécifications techniques et les fiches produits ne vous renseignent davantage sur ce pour quoi vous payez, laissez-nous vous expliquer les quelques différences entre les matériels les plus courants et vous guider dans la création d’une telle infrastructure.

Première étape : choisir entre Serveur et Workstation

Généralement, à moins que vous ne soyez dans l’Edge et que vous ayez recours à des COM ou à des SBC, vous aurez, pour votre infrastructure AI, le choix entre des serveurs ou des workstations. Les différences résident surtout au niveau du facteur de forme, de la consommation énergétique et de l’évolutivité des composants. Une workstation vous permettra d’avoir accès rapidement à de la puissance de calcul, en étant disposée sous les bureaux de vos développeurs, là où un serveur, plus bruyant, nécessitera une installation électrique et un système de refroidissement en amont de son fonctionnement, pour éviter la surchauffe et la mort prématurée de ses composants.

Il peut y avoir, en général, entre deux et quatre GPU dans une workstation, alors qu’un serveur adapté, de taille 4U pourra, selon le modèle, en contenir jusqu’à dix (explication de l’unité de mesure des serveurs en dessous).

https://en.wikipedia.org/wiki/Rack_unit

Le coût est un facteur à prendre en compte lors de ce choix, mais l’évolutivité doit être gardée à l’esprit, il sera plus évident d’ajouter une carte graphique dans six mois dans votre serveur que de racheter une seconde workstation car vous manquez de puissance pour être compétitif.

Evidemment, personne ne vous demande de transformer votre local technique en Datacenter, une simple baie 20U sur roues, agrémentée du nécessaire de mise à la terre, d’une double adduction électrique et Ethernet, d’un onduleur et d’un switch 24 ports fera l’affaire (avec votre/vos serveur(s) évidemment).

Deuxième étape : choisir son/ses GPU(s)

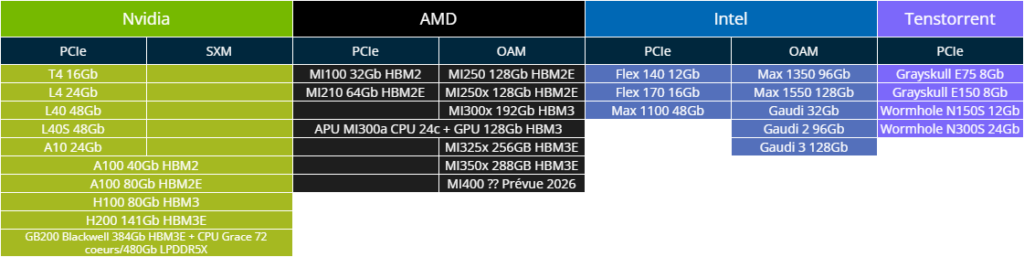

Pour les GPU, vous pouvez (et vous n’avez guère le choix) vous orienter vers Nvidia, AMD ou Intel. Même si des challengers commencent à émerger, avec des puces dédiées pour certains traitements algorithmiques, comme Groq, Etched ou Tenstorrent, ce sont bien les cartes des leaders du marché que vous pourrez vous procurer, de manière directe auprès de revendeurs agrées, ou à moindre coût chez des brokers IT.

Le GPU, c’est réellement le composant qui permet la mise à l’échelle de l’IA, avec la parallélisation massive des calculs, qui peineraient à être effectués aussi rapidement sur de “simples” processeurs x86.

Nvidia, leader incontesté et bientôt roi de la Bourse, propose historiquement deux gammes de GPU : Les Quadro et les Tesla. Les premières sont plus anciennes et forcément moins puissantes, tandis que les Tesla, et leurs versions actuelles, à partir de la génération Ampere, sont beaucoup plus performantes et réellement optimisées pour les tâches liées au Machine Learning et à l’IA.

Vous trouverez, sur des Clouds Providers tels AWS, GCP ou Azure, des offres de Cloud Computing w/ GPU avec des A100 pour 5€ par heure et des H100, version plus récente encore, à partir de 13€ par heure, mais elles sont également disponibles à l’achat pour quelques milliers d’euros chacune.

AMD et Intel proposent également leurs GPU, avec les gammes Instinct et Gaudi respectivement, mais leur incompatibilité avec CUDA, le Framework utilisé par de nombreux développeurs pour le portage des modèles, les rends quelque peu moins attractifs.

Vous trouverez ci-dessous un tableau récapitulatif des modèles de GPU par constructeur et par format. La quantité de mémoire allouée à chaque accélérateur est à prendre en compte, en fonction du nombre de paramètre des modèles utilisés, mais la puissance brute de chaque puce, exprimée en TFlops (équivalente à un trillion d’opérations en virgule flottante par seconde) est réellement l’élément à considérer.

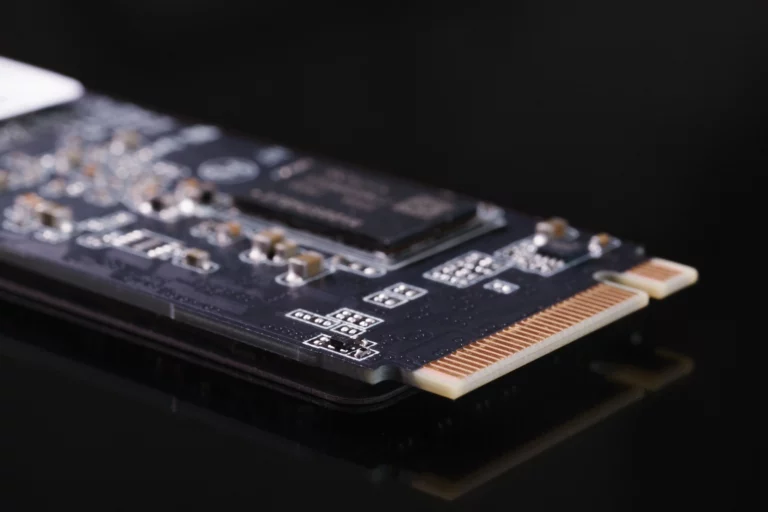

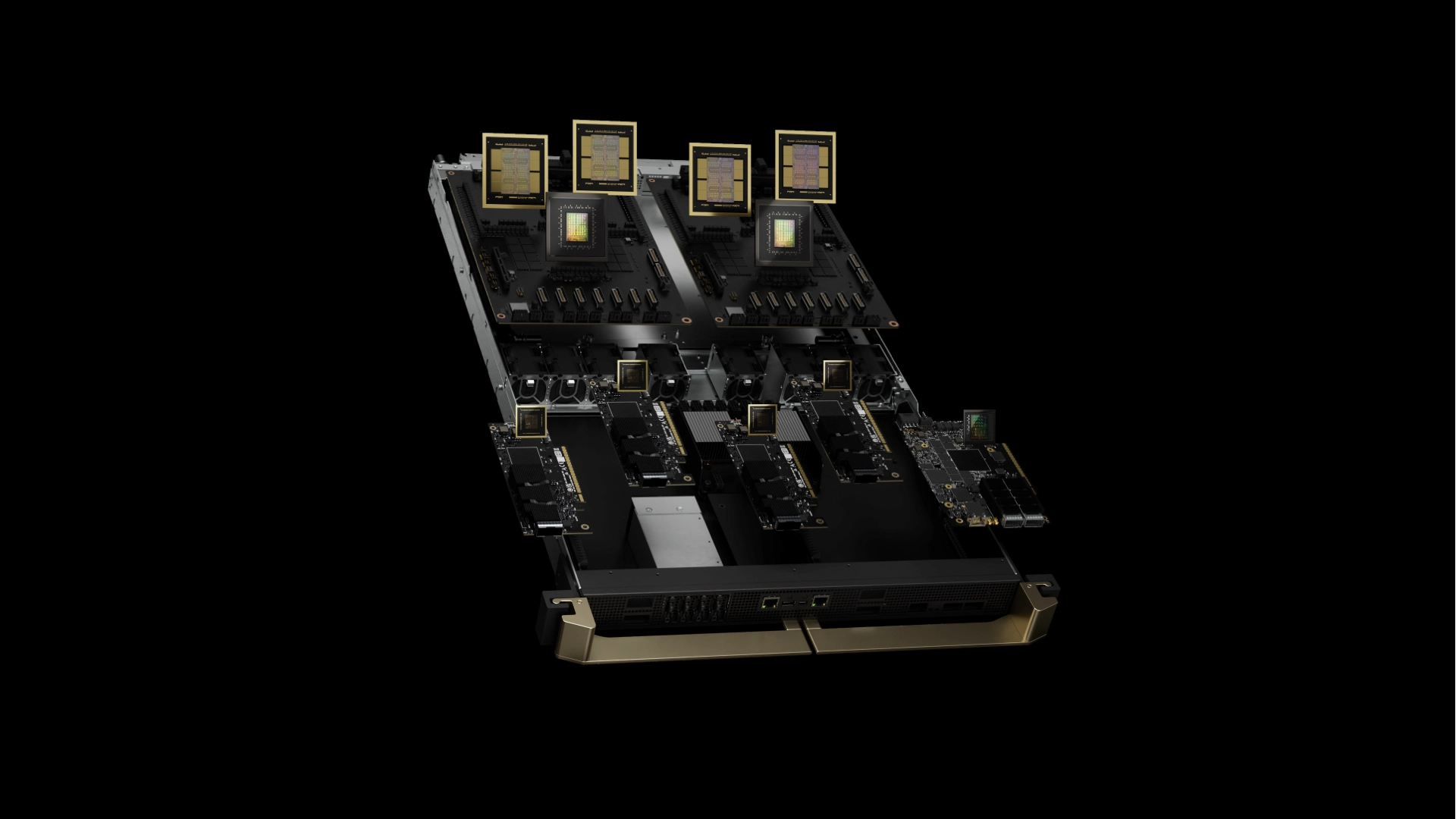

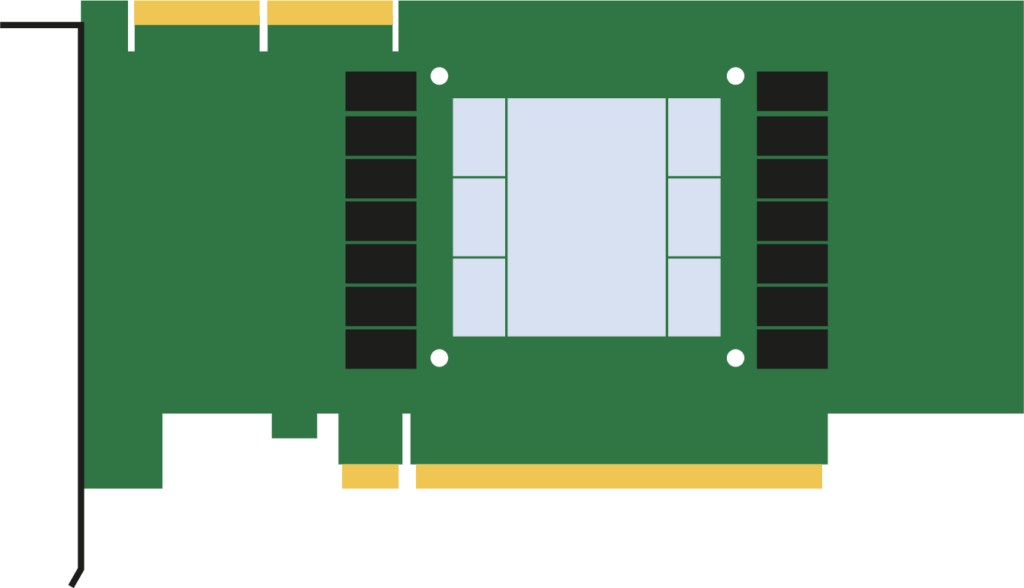

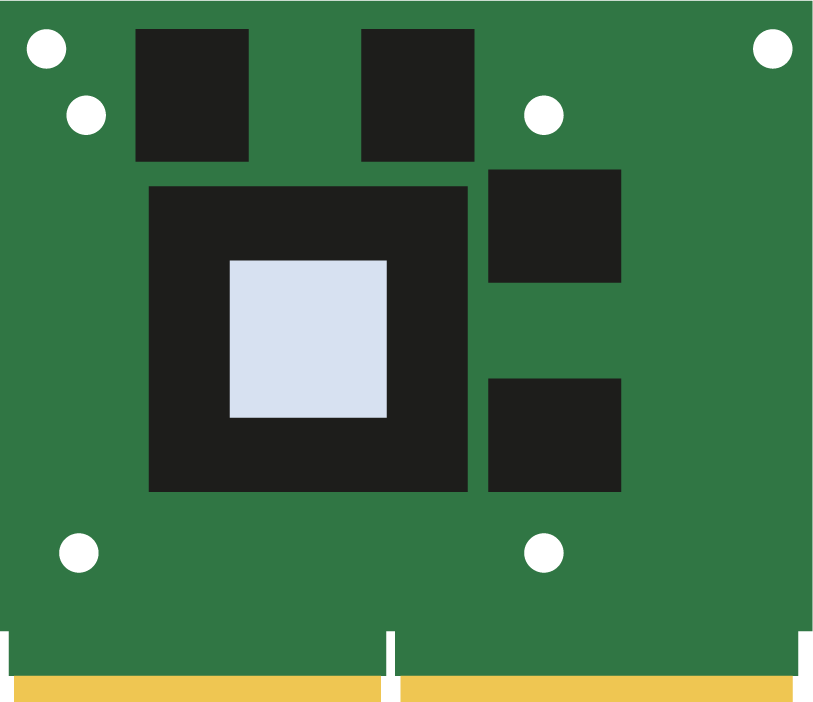

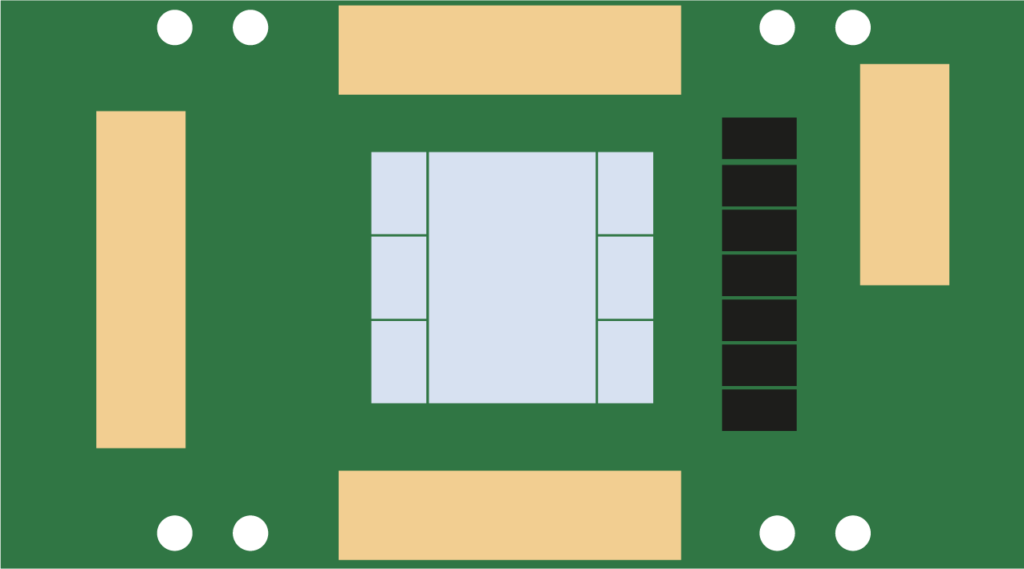

Dans le cas du choix d’un GPU pour votre serveur, il faudra porter une attention toute particulière sur le format de celui-ci. Il existe trois facteurs de forme principaux pour les GPU récents : le PCIe, le MXM et les formats SXM/OAM. Le MXM est utilisé principalement dans les laptops et dans l’informatique embarquée/ l’IoT, tandis que les deux autres sont majoritairement destinés aux workstations et aux serveurs.

Les GPU PCIe sont compatibles avec des workstations, récentes ou plus anciennes, et sont facilement interchangeables entre les systèmes, alors que les GPU aux formats SXM et OAM (pour Nvidia et AMD/Intel respectivement), bien que plus performants que leurs homologues PCIe, sont bien souvent contraints de fonctionner dans des systèmes spécifiques et propriétaires.

Vous devriez être familier avec les cartes PCIe, qui sont le standard pour les cartes additionnelles destinées aux ordinateurs de bureaux (pour ajouter une carte WiFi, une carte son, une carte graphique pour des jeux-vidéos, …).

Il existe de plus, en fonction des modèles de GPU, différentes générations de SXM, chacune avec des différences physiques empêchant les changements de cartes entre les plateformes. En contrepartie, vous bénéficierez de plus de mémoire associée à votre GPU, d’une interconnexion aisée jusqu’à huit GPU par machine, d’interfaces plus rapides, de partage de mémoire entre les puces et, dans le cas de l’inférence, de TFlops plus élevés (en FP64, FP32, BF16, INT8, …).

Troisième étape : correctement provisionner son/ses serveur(s)

Une fois le ou les GPU sélectionnés pour votre serveur, il vous faudra vous assurer que les autres composants, CPU (le processeur), RAM (la mémoire-vive) et PSU (l’alimentation) sont suffisamment adéquat pour ne pas créer de goulot d’étranglement, ce qui pourrait limiter les performances de votre accélérateur.

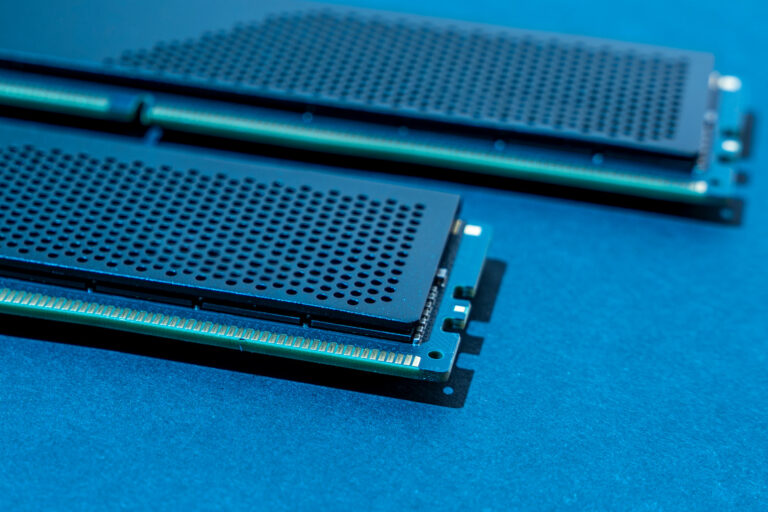

Il est fortement recommandé, pour vos processeurs, d’avoir recours à des Xeon de dernière ou d’avant-dernière génération coté Intel, et à des CPU Epyc coté AMD. Vous pouvez également opter pour des processeurs ARM avec la gamme Altra ou One d’Ampere, mais certaines incompatibilités avec les logiciels peuvent être attendues. Un minimum de 32 vCPU est aussi conseillé, et coté mémoire-vive, en fonction des tailles de modèles d’IA et de leur nombre de paramètres, de systèmes allant de 128Gb à 2Tb de RAM sont préconisés. Encore une fois, le choix du serveur est ici plus cohérent, vous pourrez y loger entre 16 et 24 barrettes de RAM, alors qu’une workstation ne possède bien souvent que 8 à 12 emplacements.

Enfin, une alimentation redondée est un must-have, notez que celle-ci dépassera, en fonction du nombre de GPU dans votre serveur, très rapidement le Kilowatt.

Si vous avez opté pour plusieurs serveurs, vous devrez probablement vérifier l’installation électrique de votre local technique, ou du bureau dans lequel se trouvera votre baie (même si la tranquillité acoustique de vos collaborateurs pourra être troublée…).

Quatrième étape : porter attention aux SLA

Le dernier point est lié aux SLA et aux garanties. Si vous achetez un système neuf, que vous avez-vous-même configuré en ligne, vous veillerez à, en fonction de la criticité de vos opérations et de vos activités, prendre les mesures nécessaires afin d’avoir des GPU de remplacements prêt à être installés en cas de panne et, à minima, une intervention à distance ou sur site en quelques heures.

Dans le cas d’achat de matériel d’occasion, pas de garanties, veillez donc à pouvoir être en mesure d’effectuer vous-même les remplacements.

Dernière étape : opérer et maintenir votre infrastructure

Une fois les équipements reçus, les baies montées, les serveurs allumés et les configurations effectuées, vous êtes (normalement) prêts à lancer vos premières opérations ! Veillez à correctement documenter les processus que vous avez mis en place quant à l’exploitation de votre infrastructure IA, à conserver tous les documents qui y sont liés, et à effectuer une analyse de risque : est-ce que cette infrastructure peut représenter un risque pour mon organisation ? Est-ce que les données qui y transitent sont sécurisées ? Est-ce que cela n’enfreint pas une Politique interne, un code de conduite, ou des obligations légales ou contractuelles ?

Vous pouvez même opter pour des solutions de cybersécurité adaptées, qui utilisent de l’IA pour détecter les vulnérabilités et défendre votre organisation !

Vous l’aurez bien compris, ce n’est pas chose aisée que de mettre en œuvre une telle infrastructure, mais la solution de facilité ; le Cloud ; présente elle aussi des inconvénients…

—

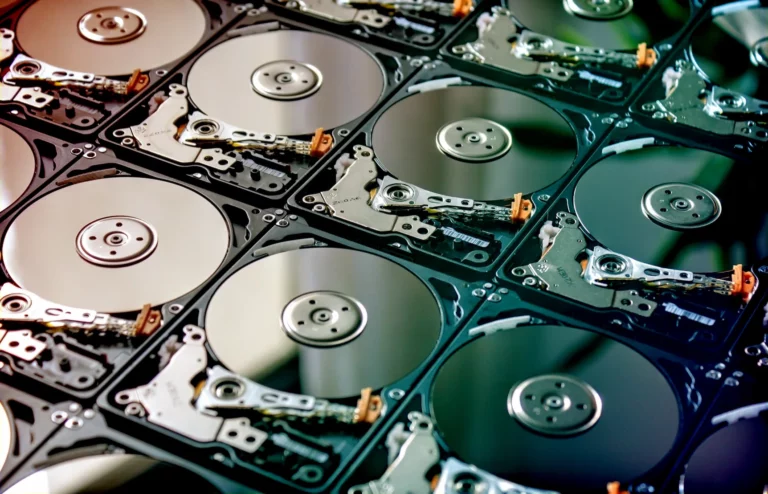

Chez SIENNA, nous avons les solutions pour vous fournir des systèmes de stockage performants pour la conservation de vos données d’entraînements.

Consultez nos autres articles à cette adresse !